Blender ist seit langem ein Favorit unter Animatoren, um atemberaubende Animationen zu erstellen und eine seiner bemerkenswerten Funktionen ist die Fähigkeit, Charaktere lippensynchron zu animieren. Die Lippensynchronisation in Blender ist ein wichtiger Prozess, um animierte Charaktere auf natürliche Weise sprechen zu lassen. Ohne sie könnten Ihre Charaktere steif wirken oder nicht mit ihrem Dialog übereinstimmen.

Diejenigen, die gerade erst mit Blender begonnen haben, könnten sich von der komplexen Oberfläche und den zahlreichen Einstellungen der Software überwältigt fühlen. Aus diesem Grund helfen wir Ihnen, die wichtigsten Schritte für eine effektive Lippensynchronisation in Blender zu verstehen und geben Ihnen Empfehlungen, wenn Sie eine schnelle Lösung für die Lokalisierung Ihrer Inhalte benötigen.

In diesem Artikel

- Wie man einen Lippensynchronisationseffekt in Blender erstellt

- KI Lippensynchronisation in Filmora: Erstellen Sie Ihre Videoübersetzung

- Lippensynchronisation im direkten Vergleich: Blender vs. Filmora

- Der Einfluss der Lippensynchronisationstechnologie auf die Videoproduktion

- Herausforderungen beim Einsatz der KI Lippensynchronisationstechnologie

- Wie sorgt man dafür, dass Lippensynchronisations-Animationen realistischer aussehen?

Teil 1. Wie man einen Lippensynchronisationseffekt in Blender erstellt

Bei der Lippensynchronisation wird die Form des Mundes Ihrer Figur an die gesprochenen Worte in Ihrer Audio-Spur angepasst. Um Ihre Figur in Blender effektiv lippensynchron zu machen, müssen Sie verschiedene Gesichtsausdrücke und Mundpositionen erstellen, die mit verschiedenen Phonemen und Sounds korrespondieren.

Es gibt zwei Hauptmethoden für die Lippensynchronisation in Blender: Automatische Lippensynchronisation und manuelle Lippensynchronisation. Bei der automatischen Lippensynchronisation in Blender werden Add-ons verwendet, die Ihr Audio analysieren und entsprechende Formen und Animationen des Mundes generieren. Bei der manuellen Lippensynchronisation hingegen müssen Sie jede Mundposition manuell anpassen und mit dem Dialog synchronisieren.

Methode 1: Automatische Lippensynchronisation

Bei der ersten Methode zeigen wir Ihnen, wie Sie in Blender eine automatische Lippensynchronisation durchführen können. Diese Methode hilft Ihnen, Ihre Figur einzurichten und eine lippensynchrone Animation einfacher zu produzieren, so dass Sie sich mehr auf die kreativen Aspekte Ihres Projekts konzentrieren können, anstatt sich mit manuellen Anpassungen zu verzetteln.

Das Add-on, das Sie für die automatische Lippensynchronisation in Blender verwenden müssen, ist Rhubarb Lip Sync. Bevor Sie beginnen, laden Sie das Add-on herunter und befolgen Sie die folgenden Schritte.

- Schritt 1: Installieren Sie das Rhubarb Lip Sync Add-on

Öffnen Sie Blender und gehen Sie zu Bearbeiten > Voreinstellungen. Klicken Sie auf die Registerkarte Add-ons und dann auf Installieren. Navigieren Sie dann zu der heruntergeladenen Rhubarb Lip Sync .zip-Datei und klicken Sie auf "Add-on installieren". Aktivieren Sie das Add-on, indem Sie das Kästchen neben dem Add-on in der Liste Add-ons markieren.

- Schritt 2: Bereiten Sie Ihre Audiodatei vor

Gehen Sie zum Video Sequence Editor (VSE) und fügen Sie Ihre Audio-Spur hinzu, indem Sie Hinzufügen > Sound wählen. Suchen Sie Ihre Audiodatei und klicken Sie auf "Sound Strip hinzufügen".

- Schritt 3: Richten Sie Ihren Charakter ein:

Erstellen Sie ein Charaktermodell mit einem Rig, das Gesichtssteuerungen für Mundformen (Phoneme) und Mimik enthält. Stellen Sie sicher, dass die Figur Form-Keys oder knochengesteuerte Steuerelemente für die verschiedenen Mundpositionen hat.

Spielen Sie dann Ihre Animation ab, um die Lippensynchronisation in Aktion zu sehen. Wenn Ihr Gesicht steif wirkt, können Sie dem Kiefer Knochen hinzufügen, um die Bewegung zu verbessern und einen flüssigeren, natürlicheren Ausdruck zu erzielen. Rufen Sie das Element-Menü auf und wählen Sie Gesicht.

Diese Schritt-für-Schritt-Anleitung ist die vereinfachte Version des vollständigen Prozesses zur Erstellung von Lippensynchronisationseffekten in Blender. Wenn Sie mehr darüber wissen möchten, wie das geht, können Sie sich das folgende Video ansehen.

Methode 2: Manuelle Lippensynchronisation

Die zweite Methode zur Erstellung der Lippensynchronisation in Blender besteht darin, sie manuell einzurichten. Ganz gleich, ob Sie an 2D- oder 3D-Animationen arbeiten, dieser Ansatz gibt Ihnen mehr Kontrolle und ermöglicht präzise Anpassungen, so dass Sie jede Mundbewegung genau auf den Dialog abstimmen können.

Für die manuelle Lippensynchronisation in Blender müssen Sie zunächst Ihr Modell riggen. Dann umfasst der Prozess mehrere wichtige Schritte:

- Erstellen von Mundposen: Entwerfen Sie eine Vielzahl von Mundposen, die den verschiedenen Phonemen entsprechen und die Ihnen als Asset-Bibliothek für die Lippensynchronisation dienen werden.

- Hinzufügen von Posen zu einer Asset-Bibliothek: Speichern Sie Ihre Mundposen in einer Asset-Bibliothek, damit Sie während des Animationsprozesses leicht darauf zugreifen können.

- Einrichten einer Animationsaktion: Erstellen Sie eine neue Animationsaktion speziell für die Lippensynchronisation. So können Sie Mundbewegungen getrennt von anderen Animationen verwalten.

- Keyframing von Mundposen: Keyframing der Mundposen, um sie an den Dialog anzupassen.

- Verwendung des NLA Editors: Schließlich können Sie den Editor für nicht-lineare Animationen (NLA) verwenden, um Ihre Dialoge mit Körperanimationen zu kombinieren und so eine reibungslose Integration von Mundbewegungen und allgemeinen Charakteraktionen zu schaffen.

Sehen Sie sich dieses gute Video an, in dem erklärt wird, wie man in Blender eine manuelle Lippensynchronisation durchführt. Es führt Sie Schritt für Schritt durch den gesamten Prozess, vom Rigging Ihrer Figur bis hin zum Keyframing von Mundposen.

Teil 2. Die KI Lippensynchronisation von Filmora: Erstellen Sie Ihre Videoübersetzung

Während sich die Lippensynchronisation in Blender hervorragend eignet, um Ihre animierten Figuren auf natürliche Weise sprechen zu lassen, benötigen diejenigen, die ihre Figuren in mehreren Sprachen sprechen lassen möchten, die Funktion der KI Lippensynchronisation von Wondershare Filmora.

Dieses Tool, das über 20 Sprachen unterstützt, kann das Audio übersetzen und die Mundbewegungen der Charaktere automatisch lippensynchronisieren, um sie an die übersetzte Sprache anzupassen. Es ist eine effiziente Lösung für Creator, die ihre Inhalte in verschiedenen Sprachen lokalisieren möchten, ohne stundenlang die Lippenbewegungen erneut manuell anpassen zu müssen.

Wichtigste Funktionen der KI Lippensynchronisation von Filmora

- Mit der KI-Technologie von Filmora können Sie in nur wenigen Minuten Mundbewegungen automatisch mit Voiceover synchronisieren.

- Generieren Sie natürlich klingende Voiceover in mehreren Sprachen mit perfekt synchronisierten Lippenbewegungen

- Fügen Sie Untertitel hinzu und passen Sie sie genau an, mit der Möglichkeit, sie herunterzuladen und nach Ihren Wünschen zu bearbeiten.

- Nutzen Sie die KI-Übersetzung von Filmora mit über 90% Genauigkeit für die reibungslose Erstellung mehrsprachiger Inhalte.

- Verwandeln Sie Sprache mit der KI Lippensynchronisation in Magie.

- Akzente verschwinden, Authentizität bleibt mit synchronisierten Lippen.

- Synchronisation in jeder Sprache, die Lippen folgen einwandfrei.

Schritt-für-Schritt-Anleitung für KI Lippensynchronisationseffekte in Filmora

- Schritt 1: Installieren Sie die neueste Version von Filmora

Stellen Sie sicher, dass Sie die neueste Version von Filmora installiert haben. Sie können das Tool von der offiziellen Webseite aktualisieren oder herunterladen und den Installationsanweisungen folgen.

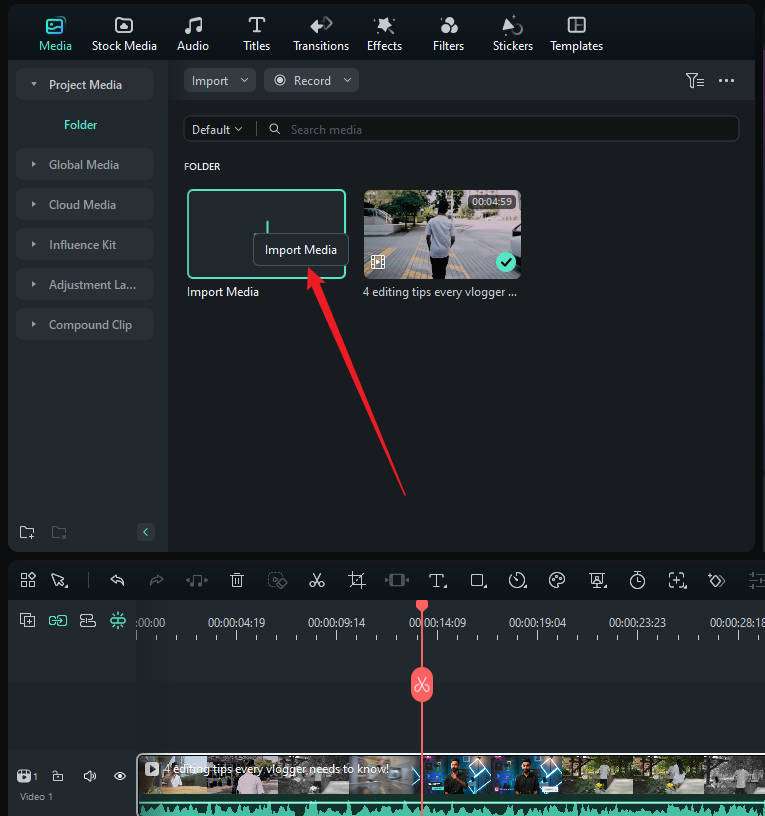

- Schritt 2: Erstellen Sie ein neues Projekt und importieren Sie Ihr Video

Klicken Sie im Filmora-Startfenster auf "Neues Projekt". Fügen Sie dann Ihr Video hinzu oder importieren Sie es in den Arbeitsbereich für die Bearbeitung.

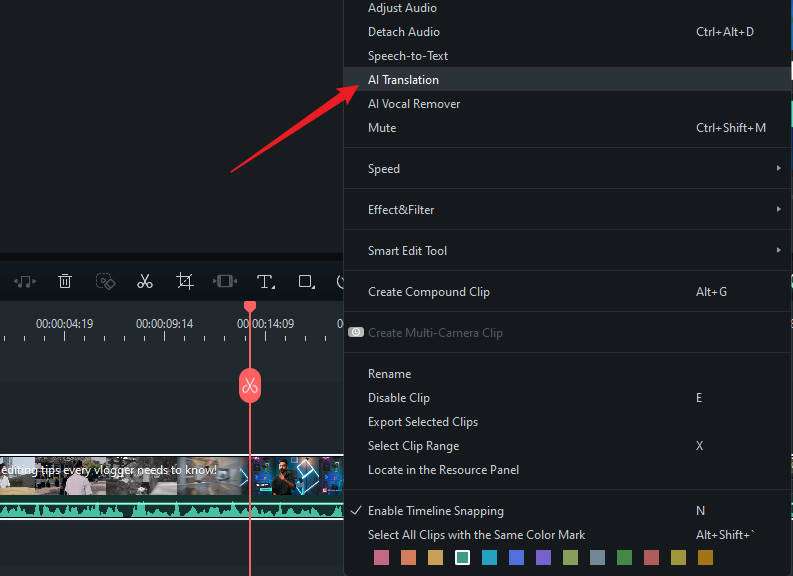

- Schritt 3: Aktivieren Sie die KI Lippensynchronisation

Klicken Sie dann mit der rechten Maustaste auf das Video und wählen Sie "KI Übersetzung".

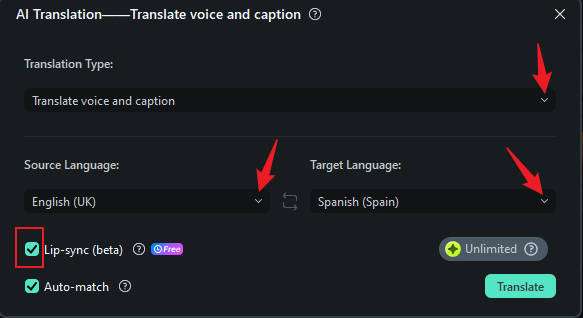

Wählen Sie im Fenster der KI Übersetzung den Übersetzungstyp "Stimme und Text". Wählen Sie Ihre Ausgangs- und Zielsprache und aktivieren Sie die Option "KI Lippensynchronisation", um die Lippensynchronisation zu aktivieren.

- Schritt 4: Bearbeiten und Anpassen des Untertitels

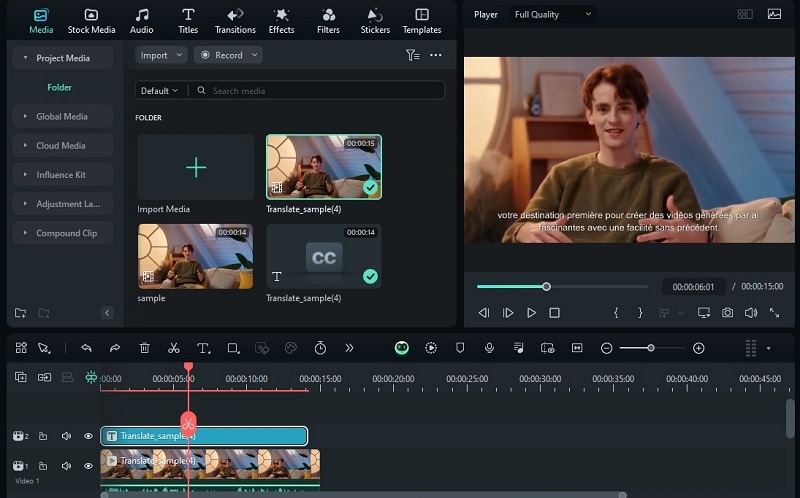

Nach ein paar Minuten sehen Sie die Ergebnisse in den Projektmedien. Es wird ein separates Video mit Lippensynchronisation in der neuen Sprache und den entsprechenden Untertiteln geben.

Um den Untertitel zu bearbeiten, können Sie auf der Zeitleiste auf die Spur des Untertitels doppelklicken und die gewünschten Anpassungen vornehmen.

Vorteile der Filmora KI Lippensynchronisationsfunktion

Angesichts des wachsenden Bedarfs an mehrsprachigen Inhalten hat die KI Lippensynchronisation von Filmora viele Vorteile. Bei Animationen können Sie damit viel Zeit sparen, da Sie die Lippenbewegungen nicht mehr für jede Sprachversion manuell anpassen müssen.

In anderen Bereichen kann die KI Lippensynchronisation von Filmora auch die Videoproduktion für Vermarkter, Pädagogen und Creator optimieren, die schnell mehrsprachige Inhalte erstellen müssen. Weitere Einzelheiten finden Sie in der nachstehenden Tabelle.

| Gruppe | Vorteile | Beispiele für die Verwendung |

| Wichtige Meinungsbildner (KOLs) | Übersetzen und synchronisieren von Videos mit Sprechertext in verschiedene Sprachen. |

Erstellen von Video-Blogs in mehreren Sprachen. Förderung von globalen Markenkampagnen in den sozialen Medien. |

| Unternehmensmitarbeiter |

Erstellung von Schulungsvideos in mehreren Sprachen mit synchronisierten Lippenbewegungen. Erleichterung einer geschmeidigen Kommunikation und Schulung für multinationale Teams. |

Entwicklung von mehrsprachigen Schulungsmodulen. Erstellen von Onboarding-Videos für globale Teams. |

| Content Creator | Erreichen einer neuen Zielgruppe durch die Lokalisierung von Inhalten. |

Lokalisierung von Lernvideos für verschiedene Zielgruppen. Produktion von mehrsprachigen Unterhaltungsinhalten. |

| Bildungsinstitutionen |

Teilen von Bildungsressourcen mit internationalen Partnern und Studenten. Bereitstellung von Lehrvideos in mehreren Sprachen. |

Erstellung mehrsprachiger Lehrvideos. Zusammenarbeit bei internationalen Forschungsprojekten. |

| Marketing Teams |

Erstellen von Anzeigen in verschiedenen Sprachen für eine bessere Marktdurchdringung. Verbessern der Effektivität von Marketingkampagnen, indem Sie das lokale Publikum ansprechen. |

Erstellung von lokalisierten Werbekampagnen. Erstellung mehrsprachiger Werbevideos. |

Neben der Lippensynchronisation kann Filmora Ihnen auch bei der Vertonung und Aufnahme von Voiceovers für Ihr Video helfen. Sie können ganz einfach das Original-Audio ersetzen oder einen neuen Kommentar hinzufügen, indem Sie direkt auf der Plattform in Echtzeit aufnehmen, während das Video abgespielt wird.

Sie können auf diese Funktion zugreifen, indem Sie oben in der Zeitleiste der Bearbeitung die Schaltfläche "Voice Over aufnehmen" auswählen. Es gibt auch die Möglichkeit, das Projekt stumm zu schalten, so dass Sie das vorhandene Audio ohne Ablenkung ersetzen können.

Teil 3. Ein Vergleich der Lippensynchronisation Seite an Seite: Blender vs. Filmora

Wenn Sie immer noch verwirrt sind über die Unterschiede zwischen Blender und Filmora für die Lippensynchronisation, haben wir diesen Vergleich erstellt, um die Funktionen und die Benutzerfreundlichkeit zu verdeutlichen.

| Blender | Filmora | |

| Ideal für | Lippensynchronisation für animierte Figuren | Schnell lokalisierte Inhalte produzieren |

| Lernkurve | Steil; erfordert Zeit zum Erlernen der Oberfläche und der Tools | Einsteigerfreundlich; für Anfänger leichter zu begreifen |

| Detaillierte Einrichtung | Erfordert umfangreiche Einstellungen für das Rigging der Figuren und die Lippensynchronisation | Automatisierte Einrichtung mit KI-Unterstützung für Lippensynchronisation |

| Anpassungsfähigkeit | Hochgradig anpassbar und unterstützt verschiedene Add-ons | Bietet Optionen zur Anpassung von Untertiteln |

| Vorteile | Leistungsstarke Funktionen für detaillierte Animationen; kostenlos und Open-Source | Schnelle KI Lippensynchronisation, unterstützt mehrere Sprachen, intuitiv |

| Nachteile | Komplexe Oberfläche, zeitaufwändig für Anfänger | Weniger Kontrolle über detaillierte Animationen, keine manuellen Einstellungen für die Lippensynchronisation möglich |

Zusammenfassend lässt sich sagen, dass die Lippensynchronisation in Blender dazu dient, realistische und ausdrucksstarke Charakteranimationen zu erstellen, indem Mundbewegungen mit Audiodialogen synchronisiert werden. Die KI Lippensynchronisation in Filmora hilft dabei, automatisch Lippenbewegungen für verschiedene Sprachen zu generieren, was es Creatorn erleichtert, ihre Inhalte zu lokalisieren, ohne die Animationen für jede Sprache manuell anpassen zu müssen.

Teil 4. Der Einfluss der Lippensynchronisationstechnologie auf die Videoproduktion

Inzwischen sollten Sie wissen, wie die Lippensynchronisationstechnologie die Videoproduktion entscheidend verändert hat, sei es bei Animationen oder Live-Action-Inhalten. Wenn Sie die Lippensynchronisationstechnologie in Ihre Projekte einbeziehen, werden Sie feststellen, dass sie mehrere Aspekte Ihrer Videoproduktion verbessert:

- Bessere Erfahrung für den Zuschauer: Wenn sich der Mund einer Figur synchron mit ihrer Sprache bewegt, wirkt die Szene realistischer und fesselnder, was den Zuschauern hilft, sich besser in die Story einzufühlen.

- Verbesserte Zugänglichkeit: Für Zuschauer, die Untertitel oder Closed Captions verwenden, erleichtert die exakte Lippensynchronisation das Verfolgen der Inhalte und macht sie für alle zugänglich.

- Verbesserte Benutzerinteraktion: In interaktiven Medien wie Videospielen oder virtueller Realität sorgt eine gute Lippensynchronisation dafür, dass sich die Charaktere lebensechter und reaktionsfähiger anfühlen, was das Benutzererlebnis insgesamt verbessert.

- Schnellere Produktion: Moderne Tools zur Lippensynchronisation können den Animationsprozess beschleunigen, so dass Creator schneller realistische Dialoge erstellen und sich auf andere wichtige Aspekte ihrer Projekte konzentrieren können.

Insgesamt kann die Lippensynchronisationstechnologie die Qualität und Effektivität der Videoproduktion erheblich verbessern. Für Creator bedeutet dies effizientere Workflows und qualitativ hochwertigere Ergebnisse. Für die Zuschauer bedeutet das ein intensiveres Erlebnis.

Teil 5. Herausforderungen beim Einsatz der KI Lippensynchronisationstechnologie

Die KI Lippensynchronisationstechnologie kann die Bearbeitung zwar erheblich vereinfachen, aber Sie sollten sich über einige Herausforderungen und Risiken im Klaren sein. Diese Bedenken umfassen:

- Qualitätskontrolle

Obwohl die Automatisierung den Prozess beschleunigen kann, ist es wichtig, dass ein menschliches Auge auf die Arbeit gerichtet bleibt, um die Genauigkeit zu gewährleisten. Wenn man sich zu sehr auf die KI verlässt, kann es zu Fehlern kommen, die sich auf die Übereinstimmung der Lippensynchronisation mit dem Dialog auswirken und das Zuschauererlebnis beeinträchtigen können.

- Ethische Belange

Die Verwendung von KI für die Lippensynchronisation kann Probleme hinsichtlich der Authentizität und des Missbrauchs aufwerfen, wie z.B. die Schaffung von Deepfakes. Content Creator müssen mit diesen ethischen Fragen sorgfältig umgehen, um ihre Glaubwürdigkeit und das Vertrauen ihres Publikums zu erhalten.

- Datenschutz

Die KI Lippensynchronisationstechnologie erfordert häufig die Verarbeitung großer Datenmengen, einschließlich sensibler Informationen. Dies wirft Bedenken darüber auf, wie Daten gesammelt, gespeichert und verwendet werden.

- Begrenztes Verständnis des Kontextes

KI könnte Schwierigkeiten haben, die emotionalen Nuancen oder kontextuellen Feinheiten von Sprache zu interpretieren. Dies kann zu einer weniger natürlichen Lippensynchronisation führen, da die Technologie die beabsichtigten Emotionen oder die Intonation des Charakters nicht vollständig erfassen kann.

- Technische Einschränkungen

KI-Tools können Schwierigkeiten haben, bestimmte Arten von Audio zu verarbeiten, z.B. Hintergrundgeräusche oder sich überlagernde Dialoge. Dies kann zu Ungenauigkeiten bei der Lippensynchronisation führen, wenn die Technologie Schwierigkeiten hat, die gesprochenen Worte klar zu unterscheiden und zuzuordnen.

Teil 6. Wie sorgt man dafür, dass lippensynchrone Animationen realistischer aussehen?

Realismus war schon immer das Hauptanliegen bei der Lippensynchronisation. Wie können Sie angesichts dieser Komplexität sicherstellen, dass Ihre Lippensynchronisationsanimationen realistisch aussehen? Um eine natürliche und überzeugende Lippensynchronisation zu erreichen, gibt es einige Tipps, die Sie befolgen können, um Ihre Ergebnisse zu optimieren.

- Studieren Sie Referenzen aus dem wirklichen Leben: Beobachten Sie echte Menschen beim Sprechen, um zu verstehen, wie sich ihre Lippen, ihr Kiefer und ihre Gesichtsmuskeln bei verschiedenen Sounds und Emotionen bewegen. So können Sie diese natürlichen Bewegungen in Ihren Animationen nachbilden.

- Feinabstimmung mit Frame-by-Frame-Anpassungen: Überprüfen Sie Ihre Animation Frame für Frame, um eine präzise Synchronisierung mit dem Audio sicherzustellen. Die Übergänge zwischen verschiedenen Phonemen sind geschmeidig.

- Verwenden Sie Keyframes effektiv: Konzentrieren Sie sich auf Keyframes, die die sichtbarsten oder ausdrucksstärksten Formen des Mundes einfangen. Dadurch wird sichergestellt, dass die wichtigsten Veränderungen in der Sprache gut dargestellt werden.

- Gesichtsausdrücke hinzufügen: Integrieren Sie zusätzliche Gesichtsausdrücke, wie z.B. Augenbrauenbewegungen und Kopfneigungen, um die Sprache und die Emotionen des Charakters realistischer zu gestalten. Es ist eine einfache Geste, die aber Tiefe und Nuancen in der Animation erzeugen kann.

Fazit

Es gibt zwei Hauptmethoden für die Lippensynchronisation in Blender: Die automatische Methode, die Add-ons wie Rhubarb Lip Sync verwendet und die manuelle Methode. Beide Techniken haben ihre Vor- und Nachteile und eignen sich daher für unterschiedliche Projekttypen und Fähigkeitsstufen.

Wenn Sie hingegen Ihre Inhalte mit natürlicher Lippensynchronisation lokalisieren möchten, benötigen Sie die Filmora KI Lippensynchronisation. Diese Funktion vereinfacht den Lokalisierungsprozess und ermöglicht Creatorn die einfache Synchronisierung von Mundbewegungen mit übersetztem Audio in mehreren Sprachen.

4,7

4,7